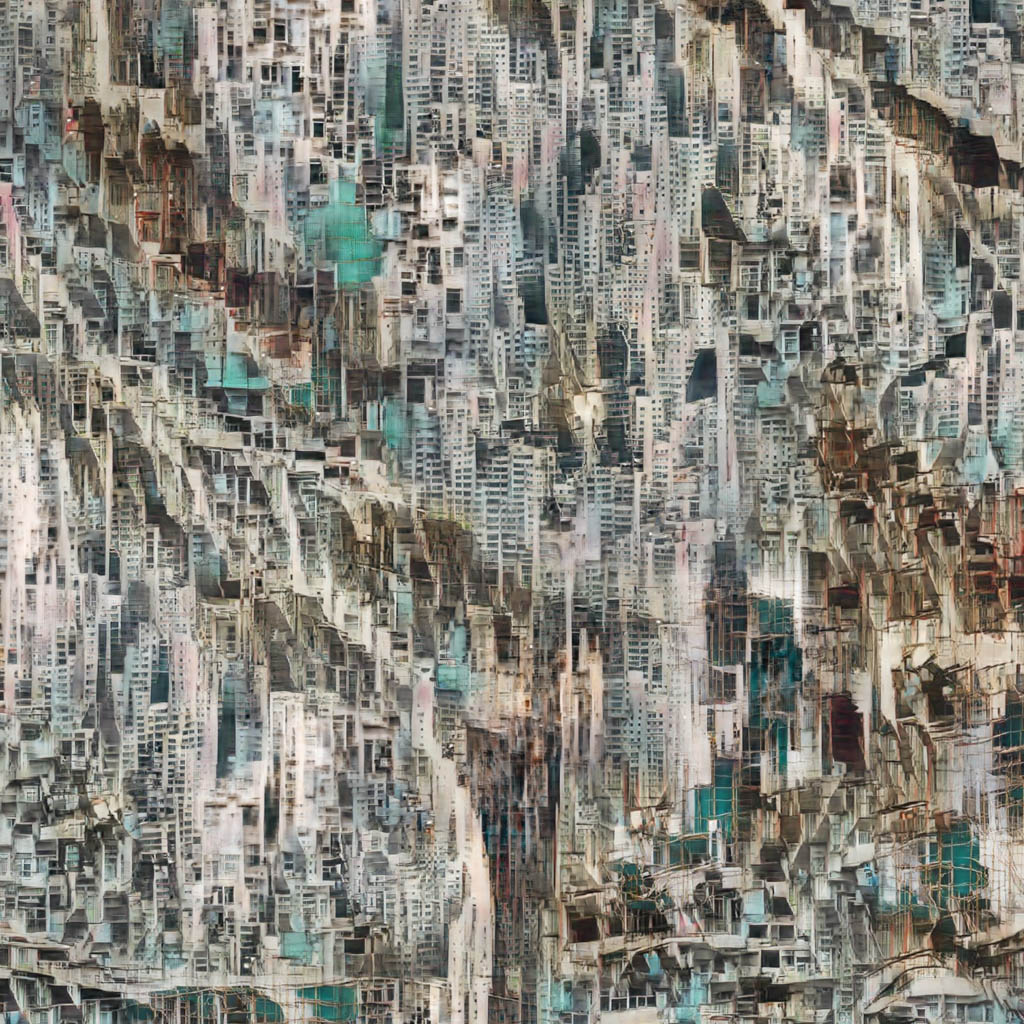

Mario Kligermann a été l’un des premiers créateurs à utiliser les réseaux de neurones convolutionnels et l’apprentissage machine pour établir le cadre d’un art génératif. […] Chacun de ces portraits, unique est généré par un programme selon une technique que l’artiste nomme Neural Glitch1

Il définit trois typologies d’algorithme utilisant de l’intelligence artificielle lors du forum Vertigo au centre George Pompidou. Nous essaierons de classer différents projets suivant ses définitions.

Ainsi courant 2015, les images de filtre de deepdream et de transfert de style sont médiatisées, Kligermann explique « there is something new about this aesthetic2 ».

Le transfert de style permet d’appliquer un style défini sur une

image ou une vidéo. L’algorithme est nourri d’une seule image stylisée

pour appliquer le style. La production de modèle de filtre n’a pu être

introduite que grâce à la création des réseaux de convolutions par Yann

LeCun. « Convolution is at the core3 » indique

Kligermann.

Ainsi, toutes ces méthodes génératives proviennent des recherches de

Yann LeCun sur les modèles de réseaux de neurones de convolutions,

appelés Convolution Neural Network ou CNN.

Développés dès les années 90, ils reposent sur des opérations de

convolution, elles sont utilisées par exemple pour flouter une image

(par le flou gaussien ou par le flou médian), pour effectuer de la

détection de contour (filtre de Sobel), ou pour augmenter la netteté

d’une image (filtre sharpen). Ces différentes opérations

conservent la relation entre les pixels et sont toutes le fruit d’une

matrice, appelé kernel de convolution qui applique une

opération sous forme d’une tuile se déplaçant dans l’image.

Le réseau de convolution détermine de lui-même quelles sont les opérations de convolution les plus pertinentes suivant le contexte par l’apprentissage. Plus précisément, par l’algorithme de back propagation, le modèle corrige les poids de chacun des neurones du réseau. Cela hiérarchise donc l’importance de chacune de ces opérations de convolution en fonction du corpus d’apprentissage4. Dominique Cardon synthétise ainsi le fonctionnement de ces modèles : « […] paver l’image en petites tuiles de pixels confiées à des segments de neurones séparés avant de les rassembler dans une autre couche du réseau5 ». Par les différentes couches de convolution du réseau, puis par d’autres fonctions comme le Pooling, les transformations de l’image sont de plus en plus petites. Ainsi « […] these will go down to being just one pixel long […] we completely removed the spatial dimension6 ». Ce passage progressif, d’image en deux dimensions à un ensemble de données linéaires, permet la classification.